- A+

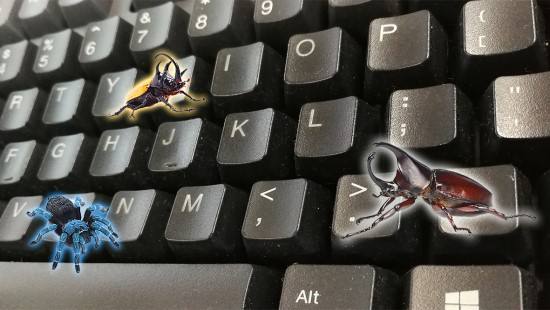

一个网站,如果想要在互联网上有很好的展现,除去有偿的SEM竞价推广,基本上就是利用搜索引擎优化规则,让网站关键词排名得到提升,也就是我们常见的SEO优化。做过SEO优化的朋友一般都了解蜘蛛抓取这个概念,那么至于说搜索引擎蜘蛛是怎样抓取网站页面的呢?

蜘蛛怎样抓取网页,首先得需要了解总共有哪些类型的蜘蛛。

搜索引擎蜘蛛是怎样抓取网站页面的

1.批量型蜘蛛。

这种蜘蛛基本上每天都是完成固定的目标和抓取任务,比如在规定抓取范围内抓取网页数量,或者网页大小,抓取时间等。

2.垂直性蜘蛛。

这种蜘蛛会特定的主题或者行业进行抓取。比如是旅游行业的蜘蛛,那么它只会抓取旅游相关的主题,其他的内容不会抓取,这类蜘蛛的难点就是需要辨识内容所属行业,目前很多垂直行业网站都是这种蜘蛛抓取。

3.增量型蜘蛛。

与批量型蜘蛛不同的是,这类蜘蛛会持续不断抓取并对已抓取页面定期更新,增量型蜘蛛一般都会保持这个状态,比如我们常见的快照抓取就是增量型蜘蛛。

其次,我们就可以考虑一下蜘蛛的抓取策略问题。抓取策略是一个非常复杂的过程,蜘蛛一般会从主URL进行抓取,然后拓展大量的URL,不过这其中就涉及到抓取顺序问题,这个抓取顺序一般就是根据抓取策略而定。当然,不管是哪种策略,它都是给网页进行综合评价,然后根据页面内容,链接权重等方面进行计算排名。

1.宽度优先策略(也称广度优先策略)。

抓取一个网页,之后按顺序对其他页面进行进一步抓取。这个过程在我们视觉体验看来非常简单,就是这个网页页面有哪些链接,然后不同的点击展开。

2.权重值策略。

典型的搜索引擎内部值算法,根据不同的页面传递的权重值,然后这个数值高低进行抓取。

3.大型网站优化策略。

一般新站刚开始抓取时间都非常少,而很多大型网站,它们几乎上刚刚更新就会收录或者更新快照等,这就是大型网站优先抓取策略。

4.深度优先策略。

针对具体站点,深度优化策略会根据一个站点的主URL,然后沿着链接不断抓取,顺着一条线路抓取完之后就会继续回到首页进行第二条链接抓取,一直到抓取完毕。

【相关阅读】蜘蛛爬虫抓取网站页面的具体流程是什么

那对网页是否更新,蜘蛛抓取又是怎样进行抓取的呢?做SEO优化的朋友一般都会保持站内的更新,至于为什么这么做可能并不清楚具体原因。其实为什么要保持站点更新,主要是由于蜘蛛抓取页面时,会根据历史参考策略进行抓取。通俗的理解就是,网页一直按照一个规律更新,那么搜索引擎会认为这个页面将来也是按照这个规律进行更新,因此蜘蛛也会按照这个规律抓取。

此外,还有用户体验型的抓取,比如我们经常搜索一个结果,内容可能并不是最新展示的,但是它展现在靠前位置,主要是这个页面的价值非常高,能够解决大部分用户需求;聚类抽样型抓取策略,即根据网页表现的属性与类似页面进行归类,被归类的页面按照相同规律进行更新。

如果蜘蛛遇到抓取内容页面,它是按怎样一个顺序进行抓取呢?

我们可以利用站长的模拟抓取方式查看,基本抓取顺序就是从上往下,从左路往右,最后是JS调用的一些内容,而且基本上是原封不动的调用。因此,我们在做网页时,尽可能的减少使用JS调用,要做优化,尽可能的将站点重要内容放在最重要的位置,比如Logo位置,Title,及导航栏目位置。

【知识分享】网站导航栏布局对整体优化有哪些影响

- Y7网络QQ群

- 482772634

-

- Y7微信公众号

- 我的微信公众号扫一扫

-